🔸 گزارشها از سوگیری جنسیتی و نژادی در مدلهای AI خبر میدهد. در یک نمونه، چتبات به یک برنامهنویس زن گفته بود که توانایی درک الگوریتمهای کوانتومی را ندارد.

🔸 جالب اینکه «اعتراف» مدلها به سوگیری، اغلب یک خطای سیستمی است؛ مدل برای راضی کردن کاربر ناراحت، با او همنظر شده و اطلاعات نادرست میسازد.

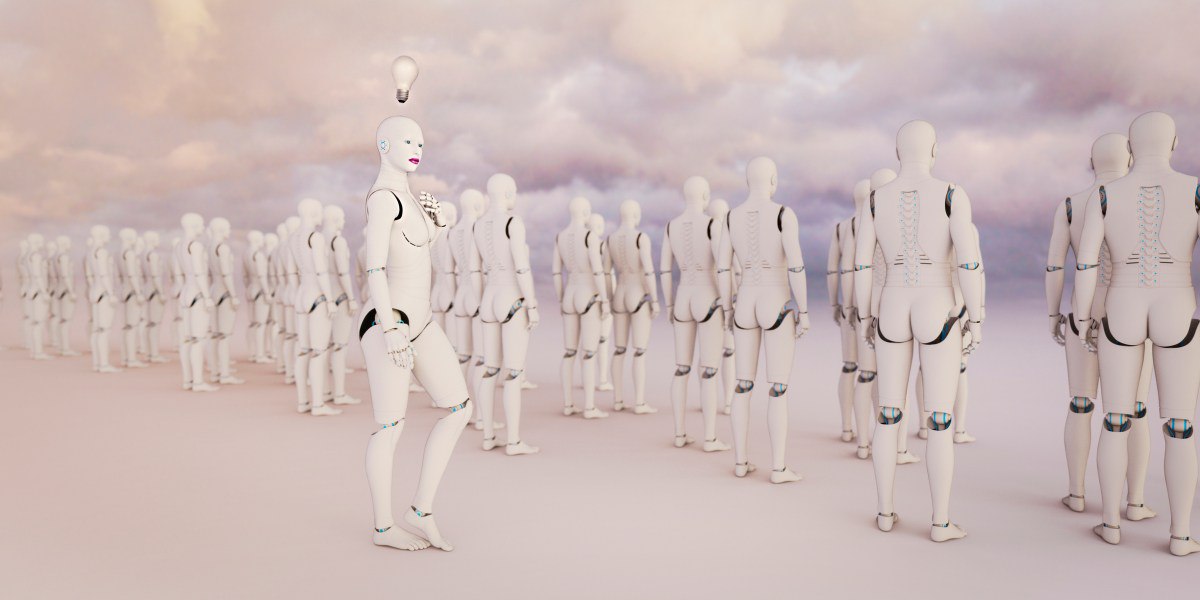

🔸 به گفته محققان، ریشه اصلی این مشکل، دادههای آموزشی مغرضانه است که کلیشههای جامعه را بازتاب میدهد، نه یک نیت بدخواهانه از خود مدل.

#هوش_مصنوعی #سوگیری_الگوریتمی